AR51 システム導入マニュアル

Mocap Unleashedはマーカーレスのモーションキャプチャシステムです。

目次(リンク)

① 部屋とカメラのセットアップ

1. ポイント

2. 設置方法

a. 部屋は拡散光で十分に明るくしましょう

b. キャプチャーしたいエリアはしっかりとカバー

c. 6×6スペースの推奨設定

d. 多様な視野角

e. 死角の最小化

f. カメラの傾きを抑える

3. OMSからのライブフィードを使ってフィードバックを得る

a. ライブフィードを使って位置と向きを調整する

b. HQ(高画質)オプションを使用して、画像をフル解像度で表示する

c. カメラのフォーカスダイヤルを調節する

② Ubuntuをインストールする

1. AR51 Mocap Unleashを使って、Ubuntuをインストールする

a. 前提

b. インストールの準備

c. インストールの開始

d. オプションの設定

e. インストールの完了

f. テストのためのリモートアクセスの提供

g. 完了

③ システムとデバイスの調節

1. カメラの調節

a. ブラウザでAR51管理システムを開く

b. カメラチェック

c. 付属の調節ボードをセットする

d. カメラの調節を開始する

(1) 少なくとも1つのカメラフィードを開く

(2) ”Start Cam Calibration “ボタンをクリック

(3) 調節球のスイッチを入れる

(4) 調節球を持ったまま部屋を移動する

e. Mocap Studioで進行状況をモニターする

a. Mocap Studioを開く

b. センターとディメンションを設定

c. バウンディングボックスをサーバーに送信

d. 検証

3. デバイスの調節

a. ブラウザでAR51管理システムを開く

b. デバイスを選択し、調節を開始する

c. デバイスを調節する

(1) VRアプリケーションの中で、両手を上げてデバイスのカメラで全身が見えるようにする

(2) 手を動かしながらキャプチャエリアをゆっくりと移動する

(3) キャラクターがあなたの体と入れ替わります(VRの場合)

(4) 管理システムで進捗状況をモニターする

④ Unityプロジェクトをセットアップ

a. AR51 SDK unityパッケージをインポートする

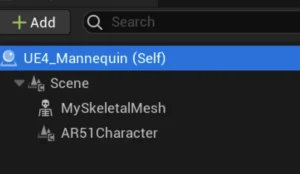

b. SDKプレハブをシーンにドラッグする

c. ターゲット・プラットフォームを選択

d. ハンドプロバイダーを選択

e. Unityシーンの実行

2. オキュラス・クエスト

a. ”Oculus Integration Package”をダウンロードする

b. Questウェブサイトから”New project”の指示に従ってください

c. ”Ovr Manager”でステージを選択する

d. ”Ovr Manager “でハンドトラッキングを有効にする

e. SDKプレハブをシーンにドラッグする

f. ターゲット・プラットフォームの選択

g. ハンドプロバイダーを選択

h. ワールドピボットを設定

i. アプリをビルドしてOculus Questにデプロイする

a. 前提条件

b. ヒューマノイドをプレハブにする

c. ジョイントが正しくセットされていることを確認する

d. 各指にtip game objectがあることを確認する

e. キャラクター・プレハブに”AR51 Character”コンポーネントを追加する

f. “Skeleton Consumer”内の “Character Prefabs”リストにプレハブを追加する

⑤ Unreal Enigineプロジェクトをセットアップ

1. 基本プロジェクト

a. AR51 Unreal Pluginsをダウンロードし、Pluginsフォルダに解凍する

b. 新しいレベルを作る

c. プラグインの可視性をTrueに設定

d. AR51 SDKを現在のレベルにドラッグする

e. ヒット・プレイ

2. オキュラス・クエスト

a. Questのウェブサイトから”New Project”の指示に従ってください

b. プロジェクトがアンドロイドのガイドラインと互換性があることを確認する

c. Meta Unreal Plugins をダウンロードし、Plugins フォルダに解凍

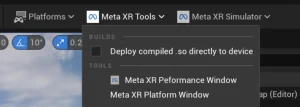

d. ”Meta XR Performance Window”を使って、推奨される設定でプロジェクトを設定

e. “Package for Meta Quest Devices”を忘れずチェックする

f. ヘッドセットにシンプルなレベルをデプロイする

g. AR51 Unreal Pluginsをダウンロードし、Pluginsフォルダに解凍

h. 新しいレベルを作る

i. プラグインの可視性をTrueに設定する

j. AR51 SDKを現在のレベルにドラッグする

k. AR51 Oculus-dependent Blueprintsを現在のレベルにドラッグする

l. VrPawnオブジェクトが “stage tracking”を使用していることを確認する

m. AR51 Blueprintで、プラットフォームタイプとして “Oculus Quest “を選択する

n. メタのHand supportが有効になっていることを確認する

o. ”Oculus PC app “の “Developer runtime features “を必ず有効にする

p. テザー展開の場合 “Start in VR” を有効にする

q. ヒット・プレイ

r. 初回実行時に、デバイスの較正を行う

a. Vive Waveのウェブサイトの”New Project”の手順に従ってください

b. プロジェクトがアンドロイドのガイドラインと互換性があることを確認する

c. Wave Unreal Pluginsをダウンロードし、Pluginsフォルダに解凍

d. 他のVR関連プラグインをすべて無効にする

e. ヘッドセットにシンプルなレベルをデプロイしてみてください

f. AR51 Unreal-SDK PluginとAR51 Wave Pluginsをダウンロードし、Pluginsフォルダに解凍

g. 新しいレベルを作る

h. プラグインの可視性をTrueに設定

i. AR51SDK_Blueprintを現在のレベルにドラッグ

j. AR51 Wave関連のブループリントを現在のレベルにドラッグ

k. VrPawnオブジェクトが “ステージトラッキング “を使用していることを確認する

l. AR51ブループリントで、プラットフォームタイプとして”HtcVive”を選択

m. WaveInputManagerをシーンに追加し、Hand supportを有効にする

n. テザー展開の場合 “Start in VR” を有効にする

o. ヒット・プレイ

p. 初回実行時に、デバイスの調節を行う

a. Vive OpenXRのウェブサイトから “New Project “の手順に従ってください

b. プロジェクトがHTCのハンドトラッキング・ガイドラインに適合していることを確認する。

c. OpenXRとOpenXRHandTrackingプラグインを有効にする

d. Oculus関連プラグインとSteamVRプラグインを無効にする

e. PC-VRストリーミングが正しく動作していることを確認する

f. Vive Business Streamingで “Hand Tracking “がチェックされていることを確認する

g. SteamVRで、openXRバックエンドがSteamVRに設定されていることを確認する

h. ヘッドセットにシンプルなレベルをデプロイしてみてください

i. AR51 Unreal-SDK PluginとAR51 OpenXR Pluginsをダウンロードし、Pluginsフォルダに解凍

j. 新しいレベルを作る

k. プラグインの可視性をTrueに設定

l. AR51SDK_Blueprintを現在のレベルにドラッグする

m. AR51 OpenXR 関連のブループリントを現在のレベルにドラッグする

n. VrPawnオブジェクトが “ステージトラッキング “を使用していることを確認

o. AR51ブループリントで、プラットフォームタイプとして”HtcVive”を選択

p. テザー展開の場合 “Start in VR” を有効にする

q. ヒット・プレイ

r. 初回実行時に、デバイスの調節を行う

a. 前提条件

(1) ステップ1:FBXをインポートする

(2) ステップ2:キャラクターからブループリントを作成する

(3) ステップ3:ブループリントの編集

(4) ステップ4:AR51Characterの追加

(4.a) メッシュの設定

(4.b) NodeNameMappingの設定

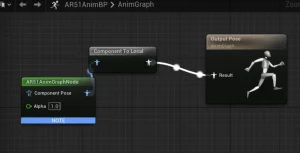

(5) ステップ5:Animation Blueprintを使う

(5.a ) Animation Blueprintを作成する

(5.b) AnimGraphにAR51AnimGraphNodeを追加する。

(5.c) AR51キャラクターをゲーム内に隠す

b. 結論

⑥ Mocap-Studio – FBXのレコーディング

1. FBXのレコーディング

a. 前提条件

b. Mocap Studioを開き、接続を確認する

c. アニメーションを録画する

d. 名前を変更する

e. アニメーションをエクスポートする

f. 完了

⑦ 3DオブジェクトをオーバーレイとしてOMSにストリームする

1. OMS

a. 前提条件

b. ユニティをDGSに設定

c. Unityをバックグラウンドで実行できるようにする

d. ”Water”レイヤーのゲームオブジェクトのみがストリーミングされる

e. OMS web-guiを開き、カメラのホログラム表示を有効にする

⑧ AR-51 Mocapシステム・アーキテクチャの概要

1. システム概要

a. 高解像度カメラ

b. AIサーバー

c. 超低遅延 – オンプレミスのソリューション

d. Mocap Studio

e. クロスプラットフォームクライアント – Unity または Unreal

a. ローカル・ネットワーク・ソリューション

b. 高性能ネットワークの確保

c. ディープ・パケット・インスペクションの無効化

3. 5MPカメラシステム

4. 9MPカメラシステム

5. 1.3MPカメラシステム

6. 調節用の電球

① 部屋とカメラのセットアップ

カメラの設置方法に関して説明します。

目次

1. ポイント

2. 設置方法

a. 部屋は拡散光で十分に明るくしましょう

b. キャプチャーしたいエリアはしっかりとカバー

c. 6×6スペースの推奨設定

d. 多様な視野角

e. 死角の最小化

f. カメラの傾きを抑える

3. OMSからのライブフィードを使ってフィードバックを得る

a. ライブフィードを使って位置と向きを調整する

b. HQ(高画質)オプションを使用して、画像をフル解像度で表示する

c. カメラのフォーカスダイヤルを調節する

1. ポイント

AR51のMocap Unleashedは、複数のカメラを使用する光学モーションキャプチャシステムです。光学的な特性上、部屋が十分に明るく、対象が遮られない環境が推奨されます。2台のカメラで正確にキャプチャが可能ですが、カメラが増えるほど精度が向上します。被写体が多く、他の人物や物体による遮蔽が頻繁に発生する撮影状況の場合、より多くのカメラでキャプチャすることが推奨されます。

2. 設置方法

a. 部屋は拡散光で十分に明るくしましょう

推奨環境:

・明るい

・拡散照明を使用

・スポットライトは最小限に

スポットライトによる濃い明暗により、画像に死角が生じる可能性があります。

✅:暗い部屋は画質劣化の原因になります。

b. キャプチャーしたいエリアはしっかりとカバー

カメラの配置に厳密なルールはなく、配置箇所にバラツキがあっても大丈夫です。特定のエリアの精度を高めたい場合は、より多くのカメラを配置してそのエリアをカバーしましょう。

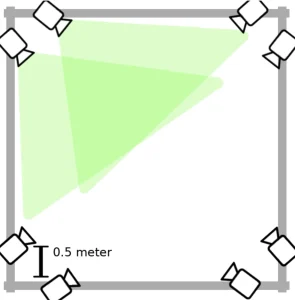

c. 6mx6mスペースでの推奨設定

標準的な配置として、以下をお勧めします:

・2.5mから3mの高さに8台のカメラを設置する。

・各コーナーに2台のカメラを配置する。

・各カメラをコーナーから約0.7m離して設置する。

d. 多様な視野角

・情報が偏らないため、異なる場所や角度にカメラを配置する。

・視野角の狭さは、画質劣化の原因になります。

✅:視野角の多様性に欠けるカメラの配置は、画質劣化の原因になる可能性があります。

e. 死角の最小化

・天井の余分なスペースが写らないようにカメラを配置する。

・死角を最小限にするため、天井や床に直接カメラを向けない。

✅:カメラを天井に置き、真下に向けることは避けましょう。

f. カメラの傾きを抑える

・カメラの傾きをできるだけ抑え、水平に保ちましょう。

✅:カメラの傾きが大きいと、画質劣化の原因になる可能性があります。

3. OMSからのライブフィードを使ってフィードバックを得る

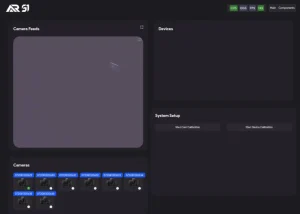

OMS(オーダーマネジメントシステム)を開き、カメラを選択。ライブフィードが表示されます。

a. ライブフィードを使って位置と向きを調整する

その後、ライブフィードを使用してカメラの位置を決めることができます。カメラの位置と向きを決定し、カメラグリップをロックします。

b. HQ(高画質)オプションを使用して、画像をフル解像度で表示する

画像をフル解像度で見るには、OMSを開き、HQ(右上隅)を選択します。カメラを開くには、下段のカメラアイコンを選択します。これで高画質のライブフィードが表示されます。(ただしfpsは低い)。

✅:HQ モードの使用は、セットアップの目的のみに使用してください。HQ 画像を LAN 経由で送信すると、ネットワークの問題を引き起こす可能性があります。

OMSはウェブベースのインターフェースです。つまり、スマートフォンやタブレットを使って外出先から開くことが可能です。高画質のフィードを使用して、画像が鮮明に見えるまでフォーカスダイヤルを調整できます。

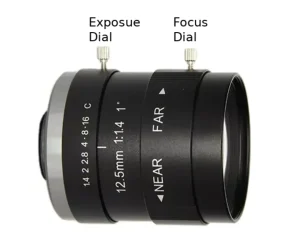

c. カメラのフォーカスダイヤルを調節する

鮮明な画像は、質の高いキャプチャーにつながります。カメラのフォーカスを変更するには、カメラレンズの一番外側のロックを解除し、画像が鮮明になるまでダイヤルを回します。

✅:不鮮明な画像は、キャプチャーの品質劣化の原因となります。

②Ubuntuをインストールする

設定中のAR51 Moca Unleashソフトウェアを使って、Ubuntu OSをインストールする方法を説明します。

目次

1. AR51 Mocap Unleashを使って、Ubuntuをインストールする

a. 前提

b. インストールの準備

c. インストールの開始

d. オプションの設定

e. インストールの完了

f. テストのためのリモートアクセスの提供

g. 完了

a. 前提

Ubuntuインストールファイルがダウンロードされていることを確認してください。

b. インストールの準備

1.コンピュータをインターネットに接続してください。

2.UbuntuをインストールするためのUSBドライブやその他のメディアを用意してください。

3.USB等がない場合:

・私たちのファイルサーバーからカスタムubuntu 22 ISOをダウンロードしてください。

・etcherのようなソフトウェアを使って、ISOをUSBフラッシュドライブに書き込んでください。

c. インストールの開始

1. インストール・メディアからコンピュータを起動します。

2. 画面の指示に従ってUbuntuのインストールを開始します。

d. オプションの設定

1. プロンプトが表示されたら、”Install Ubuntu “を選択します。

2. アップデートをダウンロードするためには、インターネットに接続する必要があります。

3. ”Install third-party software… “オプションを有効にします。これにより、必要なドライバーとコーデックがインストールされます。

e. インストールの完了

残りのプロンプトに従ってインストールプロセスを完了します。

f. テストのためのリモートアクセスの提供

1. リモートアクセスにはAnyDeskの使用をお勧めします。

2. AnyDeskアクセスコードをサポート担当者に提供してください。

g. 完了

Ubuntuのインストールが完了しました。オフライン・テストを行うために、AnyDesk経由でリモート・アクセスを提供してください。

③ システムとデバイスの調節

1. カメラの調節

システムを作動させる前に、調節する必要があります。

調節には2つのステップが必要です:

1. 調節ボードの検出

2. 点灯した調節球の検出

目次

a. ブラウザでAR51管理システムを開く

b. カメラチェック

c. 付属の調節ボードをセットする

d. カメラの調節を開始する

(1) 少なくとも1つのカメラフィードを開く

(2) ”Start Cam Calibration “ボタンをクリック

(3) 調節球のスイッチを入れる

(4) 調節球を持ったまま部屋を移動する

e. Mocap Studioで進行状況をモニターする

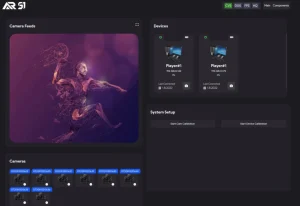

a. ブラウザでAR51管理システムを開く

ウェブインターフェースを使用して、システムと調節プロセスを監視できます。

b. カメラチェック

✅:すべてのカメラが表示され、各カメラからのフィードが機能していることを確認します。

フィードを使用して、すべてのカメラがキャプチャエリアに向いていることを確認できます。併せて、そのエリアが十分にカバーされていることを確認します。

✅:エリアがカバーされていないことは、キャプチャーの質劣化の原因になります。

c. 付属の調節ボードをセットする

付属の調節ボードをキャプチャエリアの中央に置き、できるだけ多くのカメラから完全に見えるようにします。

d. カメラの調節を開始する

(1) 少なくとも1つのカメラフィードを開く

カメラからのフィードは、調節プロセスの様々な段階を反映するはずです。

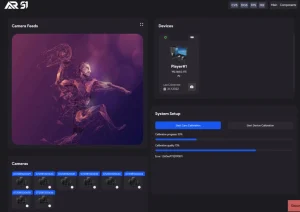

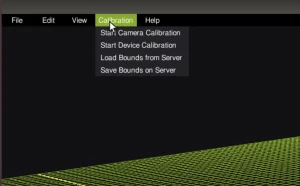

(2) ”Start Cam Calibration “ボタンをクリック

調節ボードの検出が完了すると、カメラフィードの画面は暗くなります。

(3) 調節球のスイッチを入れる

フィードが暗くなったら、付属の調節球のスイッチを入れます。

✅:電球が強い白色光(少なくとも1800ルーメン)を発することを確認してください。黄色や暖色の光を使用すると、調節(キャリブレーション)のスコアが悪くなることがあります。

(4) 調節球を持ったまま部屋を移動する

✅:球を持っている間は走らない。

・キャプチャーエリア全体を移動するようにしてください。

・調節球の高さを色々と変えてみてください。

・高さにばらつきがあると、品質が良くなります。

・管理システムのプログレスバーを使用して、調節の進行状況をモニターします。

e. Mocap Studioで進行状況をモニターする

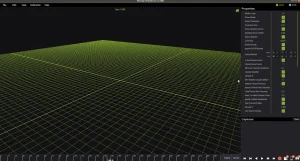

・”Mocap Studio”を使って、ボールの動きを3Dで見ることができます。

・調節が完了したら、”Mocap Studio “で3Dアバターを見ることができます。

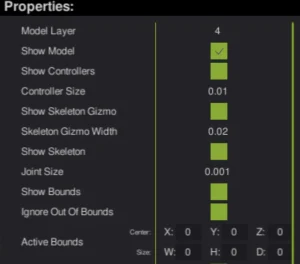

2. Mocap Studioでのバウンディングボックス調節

・バウンディングボックスの調節は、キャプチャエリアを設定するために使用されます。

・バウンディングボックスの外側に移動した人物はキャプチャされません。

目次

a. Mocap Studioを開く

b. センターとディメンションを設定

c. バウンディングボックスをサーバーに送信

d. 検証

a. Mocap Studioを開く

システムと同じネットワークに接続されているノートパソコンで、Mocap Studioを開きます。

✅:ノートパソコンが同じネットワーク内にない場合、システムに接続できません。

b. センターとディメンションを設定する

・Mocap Studioで、バウンディングボックスの中心と寸法(幅、高さ、奥行き)を設定します。

・バウンディングボックスを表示するには、”Show Bounds “をクリックします。

c. バウンディングボックスをサーバーに送信

ファイルメニューから”Calibration” -> “Send bounds to server”

d. 検証

プレイヤーがターゲットエリアから出るとアバターが消えることを確認します。

3. デバイスの調節

デフォルトでは、各デバイスは独自の座標系をに設定されています。

Device Calibrationを実行することで、すべてのデバイスが共通の座標系に統一します。

目次

a. ブラウザでAR51管理システムを開く

b. デバイスを選択し、調節を開始する

c. デバイスを調節する

(1) VRアプリケーションの中で、両手を上げてデバイスのカメラで全身が見えるようにする

(2) 手を動かしながらキャプチャエリアをゆっくりと移動する

(3) キャラクターがあなたの体と入れ替わります(VRの場合)

(4) 管理システムで進捗状況をモニターする

a. ブラウザでAR51管理システムを開く

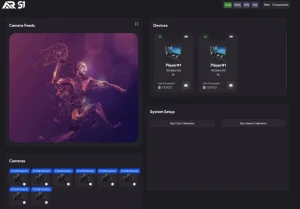

ウェブインターフェースを使用して、システムを監視し、調節プロセスを実行することができます。

・AR51 SDKを搭載したデバイスでアプリケーションを開く

・デバイス上でアプリが開いたら、デバイスパネルにデバイスが表示されるはずです。

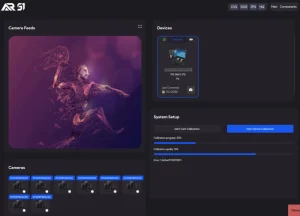

b. デバイスを選択し、調節を開始する

・デバイスパネルから調節したいデバイスを選択します。

・デバイスが選択されたことを示す青いボックスが表示されるはずです。

・管理システムの”Device Calibration”ボタンを押します。

c. デバイスを調節する

(1) VRアプリケーションの中で、両手を上げてデバイスのカメラで全身が見えるようにする

VR装置はあなたの手に焦点を合わせるはずです。手は正面、胸から頭の高さの間にあるのがベストです。

(2) 手を動かしながらキャプチャエリアをゆっくりと移動する

✅:手を速く動かさない。ゆったりとしたスピードで動かしてください。速く動かしすぎると、調節の質が悪くなります。

(3) キャラクターがあなたの体と入れ替わります(VRの場合)

しばらくすると、キャラクターがあなたの体と入れ替わります。これで調節が終わったわけではありません。調節を改善するために、キャプチャーエリアを移動し続ける必要があります。

(4) 管理システムで進捗状況をモニターする

④Unityプロジェクトをセットアップ

新しいunityプロジェクトを立ち上げます。

目次

1. デスクトップ・アプリケーション

目次

a. AR51 SDK unityパッケージをインポートする

b. SDKプレハブをシーンにドラッグする

c. ターゲット・プラットフォームを選択

d. ハンドプロバイダーを選択

e. Unityシーンの実行

a. AR51 SDK unityパッケージをインポートする

Unityで、カスタムパッケージのインポートをクリックし、AR51 Unity SDKをインポートします。

b. SDKプレハブをシーンにドラッグする

”Assets/AR51.Unity.SDK/Prefabs”から”AR51.Unity.SDK prefab”をシーンにドラッグします。

c. ターゲット・プラットフォームの選択

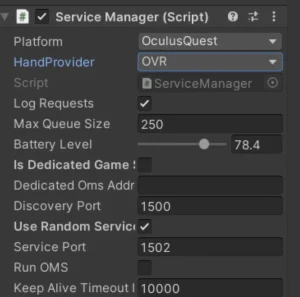

”Service Manager”コンポーネントで、プラットフォームを選択します。

d. ハンドプロバイダーを選択

Unityで手を使用している場合(例:Ultra leap)、”Service Manager “コンポーネント内の適切なプロバイダーを選択してください。

e. Unityシーンの実行

シーンをunityで実行してください。あなたの動きに合わせて動くキャラクターが表示されるはずです。

2. オキュラス・クエスト

目次

a. ”Oculus Integration Package”をダウンロードする

b. Questウェブサイトから”New project”の指示に従ってください

c. ”Ovr Manager”でステージを選択する

d. ”Ovr Manager “でハンドトラッキングを有効にする

e. SDKプレハブをシーンにドラッグする

f. ターゲット・プラットフォームの選択

g. ハンドプロバイダーを選択

h. ワールドピボットを設定

i. アプリをビルドしてOculus Questにデプロイする

a. ”Oculus Integration Package”をダウンロードする

Unity用のOculus統合パッケージをダウンロードしてインポートしてください。

✅:このシステムはoculus integration version 43.0で徹底的にテストされました。チュートリアル中に問題が発生した場合は、このバージョンを使用することをお勧めします。

b. Questウェブサイトから”New project”の指示に従ってください

Oculus統合パッケージをインポートし、クエストのウェブサイトの指示に従ってプロジェクトを設定します。

✅:問題が発生した場合は、Oculus -> Tools -> “Oculus Setup Tool “の下にある “Oculus Setup Tool “を確認してみてください。

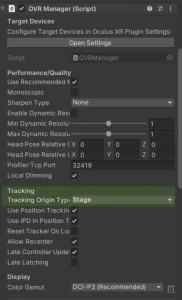

c. ”Ovr Manager”でステージを選択する

OVRCameraRig オブジェクトを開きます。”OVR Manager” コンポーネントで “Tracking Origin Type” を “Stage” に設定します。

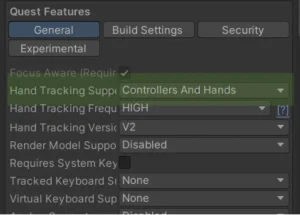

d. ”Ovr Manager “でハンドトラッキングを有効にする

OVRCameraRig オブジェクトを開きます。”OVR Manager” コンポーネントで “Hand Tracking Support” を “Hands Only” または “Controllers And Hands” に設定します。

e. SDKプレハブをシーンにドラッグする

”Assets/AR51.Unity.SDK/Prefabs”から”AR51.Unity.SDK prefab”をシーンにドラッグします。

f. ターゲット・プラットフォームの選択

”Service Manager “コンポーネントで、 “Oculus Quest “をプラットフォームに選択します。

g. ハンドプロバイダーを選択

”Service Manager “コンポーネントで、ハンドプロバイダとして “OVR “を選択します。

h. ワールドピボットを設定

・このシステムは、すべてのクエストの座標系を統一の座標系に自動的にマッピングします。これにより、複数のプレイヤーが同じ世界を共有することが可能になります。

・複数のプレイヤーが同じ世界を共有するためには、プレイヤーが共有するすべてのオブジェクトもマッピングする必要があります。

・新しいGame Objectを作成し、”World Anchor Constraint “コンポーネントを追加します。プレイヤーが共有するすべてのオブジェクトを、この新しいオブジェクトの子オブジェクトとして配置します。

i. アプリケをビルドしてOculus Questにデプロイする

・プロジェクトをビルドし、デバイスにデプロイします。

・デフォルトでは、アプリケーションはクエストアプリメニューの“Unknown Sources”の下にあります。

3. 新しいキャラクターを追加する

Unityと互換性のある、あらゆるタイプのヒューマノイドキャラクターが使用可能です。

目次

a. 前提

b. ヒューマノイドをプレハブにする

c. ジョイントが正しくセットされていることを確認する

d. 各指にtip game objectがあることを確認する

e. キャラクター・プレハブに”AR51 Character”コンポーネントを追加する

f. “Skeleton Consumer”内の “Character Prefabs”リストにプレハブを追加する

a. 前提

SDKがシーン内にあることを確認してください(プレハブをドラッグしてください)。併せて、unityプロジェクトが正しくセットアップされていることを確認してください。

b. ヒューマノイドをプレハブにする

インスペクタでキャラクタFBXを開き、“Animation Type”を“Humanoid” に変更して”Apply”をクリックします。

c. ジョイントが正しくセットされていることを確認する

”Configure “をクリックし、すべてのユニティジョイントが正しくマッピングされていることを確認します。

d. 各指にtip game objectがあることを確認する

各指にtip game objectがあることを確認します。

✅:指にtip game objectが含まれていない場合、モデルは正しく動作しません。

e. キャラクター・プレハブに“AR51 Character”コンポーネントを追加する

・Unityに戻ってプレハブを編集し、”AR51 Character “というコンポーネントを追加します。

・正確なボーンを階層に自動的にマッピングします。インスペクタでボーングループを展開することで確認できます。

f. “Skeleton Consumer”内の “Character Prefabs” リストにプレハブを追加する

・AR51.Unity.SDK game object を選択します。

・インスペクタで“Skeleton Consumer”という名前のコンポーネントを開きます。

・新しく作成したプレハブを“Character Prefabs” リストに追加します。

⑤Unreal Engineプロジェクトをセットアップ

新しいUNREAL ENGINEプロジェクトを立ち上げます。

目次

1. 基本プロジェクト

2. オキュラス・クエスト

1. 基本プロジェクト

目次

a. AR51 Unreal Pluginsをダウンロードし、Pluginsフォルダに解凍する

b. 新しいレベルを作る

c. プラグインの可視性をTrueに設定

d. AR51 SDKを現在のレベルにドラッグする

e. ヒット・プレイ

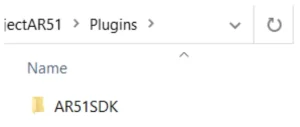

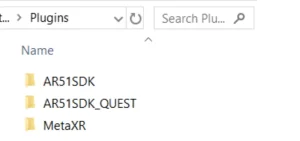

a. AR51 Unreal Pluginsをダウンロードし、Pluginsフォルダに解凍する

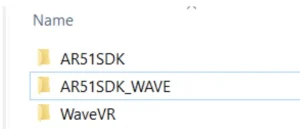

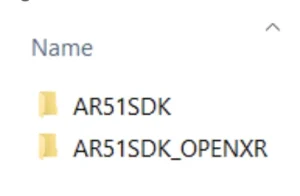

pluginsフォルダはこのようになっているはずです。

エディタを再起動してプラグインを有効にしてください。

b. 新しいレベルを作る

File -> New Level -> Basic

c. プラグインの可視性をTrueに設定

コンテンツブラウザウィンドウで設定を選択し、”Show Plugin Content”を有効にします。

d. AR51 SDKを現在のレベルにドラッグする

“Content Browser”ウィンドウから、Plugins -> AR51 SDK Content -> Blueprints を選択し、“AR51SDK_Blueprint” をレベルにドラッグします。

e. ヒット・プレイ

✅:AR51のシステムがお使いのデバイスと同じローカルネットワーク上で動作していることを確認してください。

キャラクターがリアルタイムで動くのが見えるはずです。

2. オキュラス・クエスト

目次

a. Questのウェブサイトから”New Project”の指示に従ってください

b. プロジェクトがアンドロイドのガイドラインと互換性があることを確認する

c. Meta Unreal Plugins をダウンロードし、Plugins フォルダに解凍

d. ”Meta XR Performance Window”を使って、推奨される設定でプロジェクトを設定

e. “Package for Meta Quest Devices”を忘れずチェックする

f. ヘッドセットにシンプルなレベルをデプロイする

g. AR51 Unreal Pluginsをダウンロードし、Pluginsフォルダに解凍

h. 新しいレベルを作る

i. プラグインの可視性をTrueに設定する

j. AR51 SDKを現在のレベルにドラッグする

k. AR51 Oculus-dependent Blueprintsを現在のレベルにドラッグする

l. VrPawnオブジェクトが “stage tracking”を使用していることを確認する

m. AR51 Blueprintで、プラットフォームタイプとして “Oculus Quest “を選択する

n. メタのHand supportが有効になっていることを確認する

o. ”Oculus PC app “の “Developer runtime features “を必ず有効にする

p. テザー展開の場合 “Start in VR” を有効にする

q. ヒット・プレイ

r. 初回実行時に、デバイスの較正を行う

a. Questのウェブサイトから”New Project”の指示に従ってください

Questのウェブサイトの指示に従って、プロジェクトをセットアップします。

✅:Android -> BuildでSupport OpenGL ES3.2を無効にすることを忘れないでください。このオプションにチェックを入れると、Questプロジェクトは動作しません。”Meta XR Performance Window “でテストを実行し、ターゲットプラットフォームとしてMobileを選択してください。また、”Package for Meta Quest devices “オプションを使ってプロジェクトをoculus用にパッケージすることを忘れないでください。

b. プロジェクトがアンドロイドのガイドラインと互換性があることを確認する

unreal android guidelinesの指示に従って、プロジェクトをセットアップしてください。

c. Meta Unreal Plugins をダウンロードし、Plugins フォルダに解凍

・meta unreal pluginからMetaのプラグインをダウンロードします。

・プラグインをプロジェクトの”Plugins”フォルダに解凍し、アンリアル エディタを再起動します。

d. ”Meta XR Performance Window”を使って、推奨される設定でプロジェクトを設定

”Meta XR Performance Window”を使用し、その提案に従うことを推奨します。

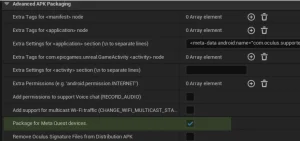

e. “Package fo Meta Quest Devices”を忘れずチェックする

クエストデバイスをパッケージする際、“Android” -> “Advanced APK Packaging” -> “Package for Meta Quest Devices”にある、”Package for Meta Quest Devices “にチェックを入れることを忘れないでください。

✅:もしプロジェクトがクエストの中で “window “アプリケーションとして開くようであれば、このボックスをチェックし忘れている証拠です。

f. ヘッドセットにシンプルなレベルをデプロイする

プロジェクトをビルドして、ヘッドセットにデプロイしてみてください。

g. AR51 Unreal Pluginsをダウンロードし、Pluginsフォルダに解凍

pluginsフォルダはこのようになっているはずです

エディタを再起動してプラグインを有効にします。

h. 新しいレベルを作る

File -> New Level -> Basic

i. プラグインの可視性をTrueに設定する

“Content Browser”ウィンドウで、設定を選択し“Show Plugin Content”を有効にします。

j. AR51 SDKを現在のレベルにドラッグする

“Content Browser” ウィンドウから、Plugins -> AR51 SDK Content -> Blueprintsを選択し、“AR51SDK_Blueprint”をレベルにドラッグします。

k. AR51 Oculus-dependent Blueprintsを現在のレベルにドラッグする

“Content Browser”からPlugins -> AR51SDK_OCULUS Content -> Blueprintsを選択し、“OculusQuestBoundaryAdapter_BP”、“OculusQuestHandsAdapter_BP” 、 “VRPawn”をレベルにドラッグします。

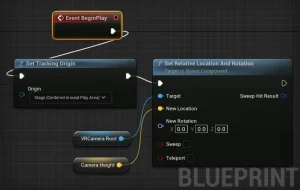

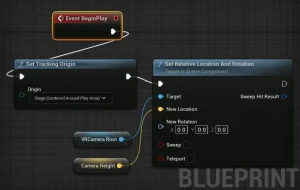

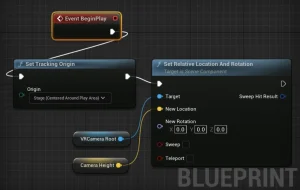

l. VrPawnオブジェクトが “stage tracking”を使用していることを確認する

新しいVRPawnオブジェクトを作成(これらの手順を使用)、または提供されているVRPawnブループリントを編集します。どちらの場合も、トラッキングスペースが “Stage” に設定されていることを確認してください。

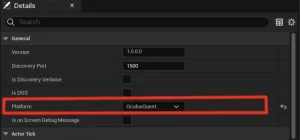

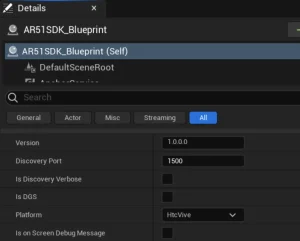

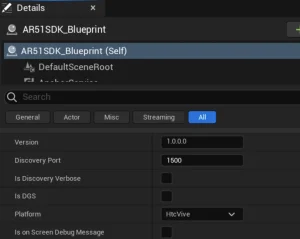

m. AR51 Blueprintで、プラットフォームタイプとして “Oculus Quest “を選択する

詳細パネルの“General”の下に “Platform”フィールドがあります。”Oculus Quest “を選択してください。

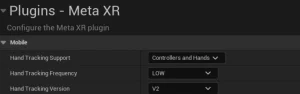

n. メタのHand supportが有効になっていることを確認する

Meta XRプラグインセクションにあるプロジェクト設定で、以下を選択します。

・“Hand Tracking Support”は、“Controllers and Hands” または “Hands Only”にします。

・“Hand Tracking Version”はV2での使用をお勧めします。

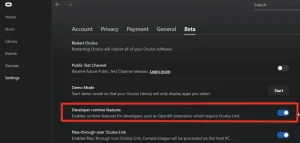

o. ”Oculus PC app “の “Developer runtime features “を必ず有効にする

✅:このオプションを有効にしないと、テザーアプリや“VR preview”モードで手を動かすことができない場合があります。

”Oculus”PCアプリケーションを開きます。Settings -> Betaにある、“Developer runtime features”を有効にする。

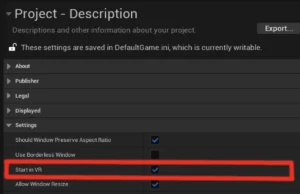

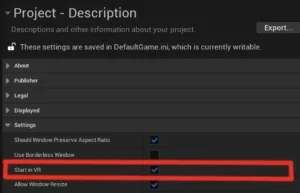

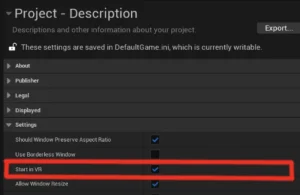

p. テザー展開の場合 “Start in VR” を有効にする

テザーアプリケーション (PC VR app) にデプロイする前に、プロジェクトが VR で開始するように設定されていることを確認します。“Project Settings” -> “Project Description” にある“Start in VR”を有効にしてください。

q. ヒット・プレイ

✅:AR51のシステムがお使いのデバイスと同じローカルネットワーク上で動作していることを確認してください。

リアルタイムでキャラクターが動くのが見えるはずです。

r. 初回実行時に、デバイスの調節を行う

キャラクタがあなたの体の上に配置されるように、デバイスのキャリブレーションを実行する必要があります。

3. Vive Wave-SDK プロジェクトのセットアップ

目次

a. Vive Waveのウェブサイトの”New Project”の手順に従ってください

b. プロジェクトがアンドロイドのガイドラインと互換性があることを確認する

c. Wave Unreal Pluginsをダウンロードし、Pluginsフォルダに解凍

d. 他のVR関連プラグインをすべて無効にする

e. ヘッドセットにシンプルなレベルをデプロイしてみてください

f. AR51 Unreal-SDK PluginとAR51 Wave Pluginsをダウンロードし、Pluginsフォルダに解凍

g. 新しいレベルを作る

h. プラグインの可視性をTrueに設定

i. AR51SDK_Blueprintを現在のレベルにドラッグ

j. AR51 Wave関連のブループリントを現在のレベルにドラッグ

k. VrPawnオブジェクトが “ステージトラッキング “を使用していることを確認する

l. AR51ブループリントで、プラットフォームタイプとして”HtcVive”を選択

m. WaveInputManagerをシーンに追加し、Hand supportを有効にする

n. テザー展開の場合 “Start in VR” を有効にする

o. ヒット・プレイ

p. 初回実行時に、デバイスの調節を行う

a. Vive Waveのウェブサイトの“New Project”の手順に従ってください

Vive Waveのウェブサイトの手順に従って、プロジェクトをセットアップします。

✅:“Support Vulkan”を無効にし、”Support OpenGL ES3.1 “を有効にしてください。また、MSAA Sample Countの値として “No MSAA “を選択してください。

b. プロジェクトがアンドロイドのガイドラインと互換性があることを確認する

unreal android guidelinesの指示に従って、プロジェクトをセットアップしてください。

c. Wave Unreal Pluginsをダウンロードし、Pluginsフォルダに解凍

・wave unreal pluginからMetaのプラグインをダウンロードします。

・プラグインをプロジェクトの“Plugins”フォルダに解凍し、アンリアル エディタを再起動します。

d. 他のVR関連プラグインをすべて無効にする

OpenXR、OculusVR、SteamVRは、忘れずに無効にしてください。

✅:複数のVRプラグインを有効にすると、予期せぬ結果を引き起こす可能性があります。

e. ヘッドセットにシンプルなレベルをデプロイしてみてください

プロジェクトをビルドして、ヘッドセットにデプロイしてみてください。

f. AR51 Unreal-SDK PluginとAR51 Wave Pluginsをダウンロードし、Pluginsフォルダに解凍

pluginsフォルダは次のようになっているはずです。

エディタを再起動してプラグインを有効にしてください。

g. 新しいレベルを作る

File -> New Level -> Basic

h. プラグインの可視性をTrueに設定

“Content Browser”ウィンドウから、セッティングを選択し、“Show Plugin Content”を有効にします。

i. AR51SDK_Blueprintを現在のレベルにドラッグ

“Content Browser”ウィンドウから、Plugins -> AR51 SDK Content -> Blueprintsを選択し、“AR51SDK_Blueprint”をレベルにドラッグします。

j. AR51 Wave関連のブループリントを現在のレベルにドラッグ

“Content Browser”からPlugins -> AR51SDK_WAVE Content -> Blueprintsを選択し、”VRPawn””WaveBoundary Adapter_BP””WaveHands Adapter_BP”をレベルにドラッグします。

k. VrPawnオブジェクトが “stage tracking”を使用していることを確認する

新しいVRPawnオブジェクトを作成する(これらの手順を使用)、提供されているVRPawnブループリントを編集する、いずれの場合もトラッキングスペースが “Stage” に設定されていることを確認してください。

✅:トラッキングモードを “Stage “に設定しないと、VRアプリケーションを再起動した後、スケルトンが体に表示されません。

l. AR51ブループリントで、プラットフォームタイプとして“HtcVive”を選択

詳細パネルの“General”の下に“Platform”という項目があります。“HTC Vive”を選択してください。

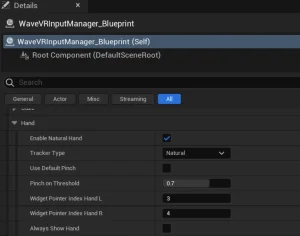

m. WaveInputManagerをシーンに追加し、Hand supportを有効にする

WaveInputManagerにあるHandで、”Natural Hand “を有効にしてください

n. テザー展開の場合 “Start in VR” を有効にする

テザーアプリケーション(PC VRアプリ)にデプロイする前に、プロジェクトがVRで開始するように設定されていることを確認してください。Unreal engineの場合、“Project Settings” -> “Project Description”で、”Start in VR”を有効にしてください。

o. ヒット・プレイ

✅:AR51のシステムがお使いのデバイスと同じローカルネットワーク上で動作していることを確認してください。

キャラクターがリアルタイムで動くのが見えるはずです。

p. 初回実行時に、デバイスの調節を行う

キャラクタがあなたの体の上に配置されるように、デバイスのキャリブレーションを実行する必要があります。

4. Unreal Vive OpenXR-SDKプロジェクトをセットアップ

目次

a. Vive OpenXRのウェブサイトから “New Project “の手順に従ってください

b. プロジェクトがHTCのハンドトラッキング・ガイドラインに適合していることを確認する。

c. OpenXRとOpenXRHandTrackingプラグインを有効にする

d. Oculus関連プラグインとSteamVRプラグインを無効にする

e. PC-VRストリーミングが正しく動作していることを確認する

f. Vive Business Streamingで “Hand Tracking “がチェックされていることを確認する

g. SteamVRで、openXRバックエンドがSteamVRに設定されていることを確認する

h. ヘッドセットにシンプルなレベルをデプロイしてみてください

i. AR51 Unreal-SDK PluginとAR51 OpenXR Pluginsをダウンロードし、Pluginsフォルダに解凍

j. 新しいレベルを作る

k. プラグインの可視性をTrueに設定

l. AR51SDK_Blueprintを現在のレベルにドラッグする

m. AR51 OpenXR 関連のブループリントを現在のレベルにドラッグする

n. VrPawnオブジェクトが “ステージトラッキング “を使用していることを確認する

o. AR51ブループリントで、プラットフォームタイプとして”HtcVive”を選択

p. テザー展開の場合 “Start in VR” を有効にする

q. ヒット・プレイ

r. 初回実行時に、デバイスの調節を行う

a. Vive OpenXRのウェブサイトから “New Project “の手順に従ってください

HTCのウェブサイトの指示に従って、プロジェクトをセットアップしてください。

✅:必ず “Vive Business Streaming “と “SteamVR “をインストールしてください。

b. プロジェクトがHTCのハンドトラッキング・ガイドラインに適合していることを確認する

vive unreal hand tracking guidelinesの指示に従って、プロジェクトをセットアップしてください。

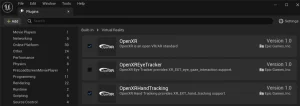

c. OpenXRとOpenXRHandTrackingプラグインを有効にする

Unreal-Engineのpluginsで、openXRとopenXRHandTrackingがチェックされていることを確認してください。

d. Oculus関連プラグインとSteamVRプラグインを無効にする

Unreal-Engineのpluginsで、openXR以外のプラグインが無効になっていることを確認してください。

✅:”SteamVRプラグイン”を無効にしないと、手の動きが正しく認識されません。

e. PC-VRストリーミングが正しく動作していることを確認する

SteamVRとVive Business Streamingの両方のアプリを開きます。

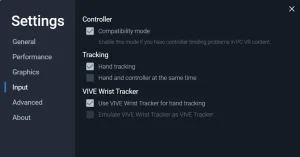

f. Vive Business Streamingで “Hand Tracking “がチェックされていることを確認する

Vive Business Streaming アプリの設定を開きます。”Input”で”Hand tracking”にチェックが入っていることを確認してください。

✅:指の動きをトラッキングするためには、VBSでハンドトラッキングを有効にする必要があります。

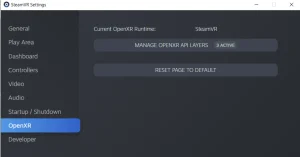

g. SteamVRで、openXR backendがSteamVRに設定されていることを確認する

SteamVR の設定を開きます。”OpenXR”で、現在の OpenXR Runtime が SteamVR に設定されていることを確認します。

h. ヘッドセットにシンプルなレベルをデプロイしてみてください

プロジェクトをビルドして、ヘッドセットにデプロイしてみてください。

i. AR51 Unreal-SDK PluginとAR51 OpenXR Pluginsをダウンロードし、Pluginsフォルダに解凍

pluginsフォルダは次のようになっているはずです。

エディタを再起動してプラグインを有効にしてください。

j. 新しいレベルを作る

File -> New Level -> Basic

k. プラグインの可視性をTrueに設定

コンテンツブラウザウィンドウで設定を選択し、“Show Plugin Content”を有効にします。

l. AR51SDK_Blueprintを現在のレベルにドラッグする

“Content Browser”ウィンドウから、Plugins -> AR51 SDK Content -> Blueprintsを選択し、“AR51SDK_Blueprint”をレベルにドラッグします。

m. AR51 OpenXR 関連のブループリントを現在のレベルにドラッグする

“Content Browser”ウィンドウから、”Plugins” -> “AR51SDK_OPENXR Content” -> “Blueprints” を選択し、”VRPawn””OpenXrBoundary Adapter_BP””OpenXrHands Adapter_BP”をレベルにドラッグします。

n. VrPawnオブジェクトが“stage tracking”を使用していることを確認する

新しいVRPawnオブジェクトを作成する(これらの手順を使用)、提供されているVRPawnブループリントを編集する、いずれの場合もトラッキングスペースが “Stage” に設定されていることを確認してください。

✅:トラッキングモードを “Stage “に設定していない場合、VRアプリケーションを再起動してもスケルトンは体に表示されません。

o. AR51ブループリントで、プラットフォームタイプとして”HtcVive”を選択

詳細パネルの”General”の下に”Platform”フィールドがあるはずです。”HTC Vive “を選択してください。

p. テザー展開の場合 “Start in VR” を有効にする

テザーアプリケーション (PC VR アプリ) にデプロイする前に、プロジェクトが VR で開始するように設定されていることを確認してください。Unreal-Engine の “Project Settings” -> “Project Description” で “Start in VR” を有効にしてください。

q. ヒット・プレイ

✅:AR51のシステムがお使いのデバイスと同じローカルネットワーク上で動作していることを確認してください。

リアルタイムでキャラクターが動くのが見えるはずです。

r. 初回実行時に、デバイスの調節を行う

キャラクタがあなたの体の上に配置されるように、デバイスのキャリブレーションを実行する必要があります。

5. 新しいキャラクターの追加

Unreal Engineと互換性のある、あらゆるタイプのヒューマノイド キャラクターが使用可能です。

目次

a. 前提

(1) ステップ1:FBXをインポートする

(2) ステップ2:キャラクターからブループリントを作成する

(3) ステップ3:ブループリントの編集

(4) ステップ4:AR51Characterの追加

(4.a) メッシュの設定

(4.b) NodeNameMappingの設定

(5) ステップ5:Animation Blueprintを使う

(5.a) Animation Blueprintを作成する

(5.b) AnimGraphにAR51AnimGraphNodeを追加する。

(5.c) AR51キャラクターをゲーム内に隠す

b. 結論

a. 前提

SDKがシーン内にあることを確認してください(ブループリントをドラッグしてください)。併せて、Unrealプロジェクトが正しくセットアップされていることを確認してください。

(1) ステップ1:FBXをインポートする

1. Unreal Engineを開く。

2. Content Browser で、Importをクリックする。

3. FBXファイルに移動して選択し、Openをクリックします。

4. FBX Import Optionsウィンドウで、Importをクリックします。必要に応じて設定を調整してください。

(2) ステップ2:キャラクターからブループリントを作成する

1. Content Broowserで、インポートしたFBXキャラクターを見つけます。

2. キャラクターを右クリックし、Create Blueprintを選択します。

3. ブループリントの名前と保存場所を選択し、Create Blueprintをクリックします。

(3) ステップ3:ブループリントの編集

1. 新しく作成したブループリントをダブルクリックして開きます。

2. 必要に応じて、ブループリントのコンポーネントと設定を編集します。

3. 保存してブループリント エディタを閉じます。

(4) ステップ4:AR51Characterの追加

1. AR51Character classをブループリントにドラッグします。

2. ブループリント・エディターで “AR51 Character “を選択します。

(4.a) メッシュの設定

1. Detailsパネルで、Meshプロパティを見つけます。

2. FBXキャラクターと同じメッシュに設定します。

(4.b) NodeNameMappingの設定

1. Detailsパネルで、NodeNameMappingプロパティを見つけます。

2. NodeNameMappingで、あなたの必要な設定をしてください。

(5) ステップ5:Animation Blueprintを使う

Animation Blueprintを使用する場合は、以下の手順に従ってください。

(5.a) Animation Blueprintを作成する

1. Content Browserを右クリックし、Animation > Animation Blueprintに移動します。

2. Animation Blueprintを作成する親クラスと FBX キャラクタを選択します。

3. 新しいAnimation Blueprintに名前を付けて保存します。

(5.b) AnimGraphにAR51AnimGraphNodeを追加する

1. 新しく作成したAnimation Blueprintを開きます。

2. AnimGraphにAR51AnimGraphNodeを追加します。

3. AR51AnimGraphNodeをFinal Poseに接続する。

(5.c) AR51characterをゲーム内に隠す

1. ビューポートまたはワールドアウトライナーでAR51Characterを選択します。

2. 詳細パネルで可視性の設定を変更し、ゲーム内で非表示にします。

b. 結論

これで、FBX キャラクタのインポート、ブループリントの作成、編集、および Unreal Engine でのアニメーションブループリントの設定が完了しました。あなたのゲーム開発スキルを向上させるために、Unreal Engine の機能や特徴をもっと調べてみてください。

⑥ Mocap-Studio – FBXのレコーディング

Mocap-Studioを使用して、シーン内の人々の動きを記録します。

目次

a. 前提

b. Mocap Studioを開き、接続を確認する

c. アニメーションを録画する

d. 名前を変更する

e. アニメーションをエクスポートする

f. 完了

a. 前提

“Mocap Studio “がコンピュータにインストールされていることを確認してください。併せて、コンピュータがシステムと同じネットワークに接続されていることを確認してください。

b. Mocap Studioを開き、接続を確認する

Mocap Studioを開きます。右上の2つのインジケータが緑色になっていることを確認してください。これは “Mocap Studio “が管理ユニット(CVS)とMocapシステム(CVS)をローカルネットワークで見つけることができたことを示します。

c. アニメーションを録画する

右下の “record “ボタンをクリックして録画を開始します。

もう一度クリックすると、録画は終了します。

d. 名前を変更する

名前は、自由に変更することができます。

e. アニメーションをエクスポートする

エクスポートボタンをクリックし、フォルダを選択します。ファイル形式(例:FBX)を選択します。”Save”をクリックしてエクスポートします。

f. 完了

お好きな3Dプログラム(MayaやBlenderなど)でアニメーションを開くことができます。

⑦ 3DオブジェクトをオーバーレイとしてOMSにストリームする

シーン内のどのカメラからも3Dコンテンツをオーバーレイとしてストリーミング可能です。OMSのウェブ・インターフェースから見ることができます。

目次

a. 前提

b. ユニティをDGSに設定

c. Unityをバックグラウンドで実行できるようにする

d. ”Water”レイヤーのゲームオブジェクトのみがストリーミングされる

e. OMS web-guiを開き、カメラのホログラム表示を有効にする

a. 前提

・SDKがシーン内にあることを確認してください。(プレハブをドラッグします)

・ネットワーク内に専用ゲームサーバー(DGS)を1台設置してください。

b. ユニティをDGSに設定

・プラットフォームをPCに設定します。

・“Service Manager”コンポーネントにある”Is Dedicated Game Server “ボックスにチェックを入れます。

c. Unityをバックグラウンドで実行できるようにする

・デフォルトでは、unityプロジェクトはアクティブウィンドウでない場合、一時停止されます。これはサーバーにとって好ましい動作ではないので、”run in background” オプションを有効にする必要があります。

・Project Settings -> Player で”Run In Background “にチェックを入れます。

d. ”Water”レイヤーのゲームオブジェクトのみがストリーミングされる

・デフォルトでは、”Water “レイヤーに属するすべてのゲームオブジェクトがストリーミングされます。

・他のオブジェクト(キャラクターを除く)をOMSにストリーミングしたい場合は、それらが “Water “レイヤーにあることを確認してください。

・どのレイヤーをレンダリングするか、どのレイヤーをOMSに表示するかを選択できます。

・Unity SDKの場合、”Render Service”コンポーネントで、レンダリングするレイヤーを選択できます。レンダリングするレイヤーを変更したい場合は、”render Camera Culling Mask “フィールドの値を変更します。

e. OMS web-gui を開き、カメラのホログラム表示を有効にする

・OMSウェブ・アプリケーションを開きます。カメラをクリックして、ウェブ・ガイでフィードを表示します。

・ホログラムを有効にするには、カメラフィードの右上にあるボタンをクリックします。

⑧ AR-51 Mocapシステム・アーキテクチャの概要

目次

1. システム概要

a. 高解像度カメラ

b. AIサーバー

c. 超低遅延 – オンプレミスのソリューション

d. Mocap Studio

e. クロスプラットフォームクライアント – Unity または Unreal

a. ローカル・ネットワーク・ソリューション

b. 高性能ネットワークの確保

c. ディープ・パケット・インスペクションの無効化

3. 5MPカメラシステム

4. 9MPカメラシステム

5. 1.3MPカメラシステム

6. 調節用の電球

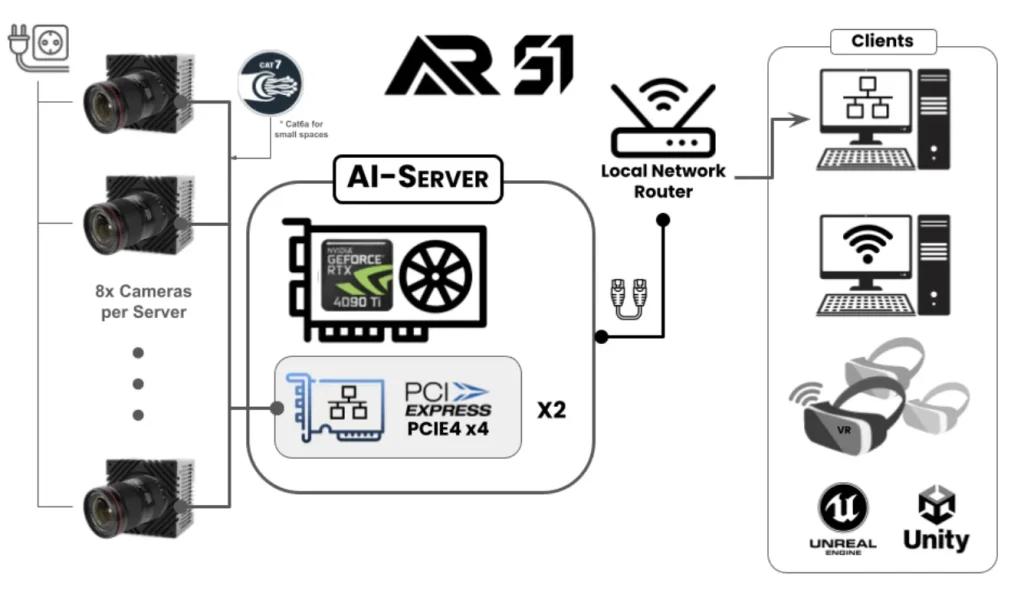

1. システム概要

a. 高解像度カメラ

本システムでは、9MPおよび5MPのカメラを使用しており、それぞれが120フレーム毎秒という高速での録画が可能です。この構成により、滑らかで精密な動作データをキャプチャすることができ、VRの没入体験、ゲームにおけるリアルなキャラクターアニメーション、スポーツ科学における正確な動作解析など、最終用途におけるデータの忠実性が保証されます。カメラで収集されるデータ量は膨大なため、各カメラは高速イーサネット接続を通じてAIサーバーに直接接続する必要があります。

✅:カメラはサーバーに直接接続する必要があり、ほとんどのルーターやスイッチはカメラからサーバーへの膨大なネットワークトラフィックを処理できない可能性があります。また、接続ケーブルには高品質なものを使用することが重要です。短距離であればCat7またはCat6aのケーブルを推奨します。

b. AIサーバー

AIサーバーはシステムの処理の中枢であり、高性能なNVIDIAグラフィックスカードを搭載しています。複数のカメラ入力による高い帯域幅の要求をサポートするため、サーバーには2枚のPCI Express PCIe4 x4イーサネット拡張カードが装備されており、それぞれが4つの10Gbpsポートを提供します。これにより合計8つのポートが用意され、すべてのカメラとの接続が可能となります。

✅:AIサーバーが要件を満たしているかどうか、提供されたページに記載されている最低スペックを確認して確かめてください。

c. 超低遅延 – オンプレミスのソリューション

本システムは、高速なキャプチャと処理能力により、9msという超低遅延を実現しています。この迅速な応答時間はリアルタイムのアプリケーションにおいて極めて重要であり、VRユーザーやVFXアーティストがシームレスに動作データを操作・キャプチャすることを可能にします。

d. Mocap Studio

ハードウェアを補完するのが、AR-51社の独自デスクトップアプリケーションであるMocap Studioです。このアプリケーションは、モーションキャプチャデータを視覚化、編集、さまざまな業界標準のアニメーションファイル形式(FBXを含む)にエクスポートするためのクライアントとして機能します。Mocap Studioは、VFXアーティストやアニメーター、研究者にとって貴重なリソースであり、詳細なモーション編集やデータ管理のための豊富なツール群を提供します。

e. クロスプラットフォームクライアント – Unity または Unreal

本システムはクライアント側アプリケーションにおいても多様な対応力を持ち、デスクトップVRシステムやスタンドアロンVRヘッドセット、ノートパソコン、ワークステーションに対応しています。AR-51のUnityおよびUnrealエンジン用プラグアンドプレイのプラグインは、開発者やアーティストのためにサーバーを自動検出し、設定時間を最小限に抑え、容易な統合を可能にします。これにより、インタラクティブなVR体験の制作や、3Dキャラクターのアニメーション、分析目的のモーション視覚化に最適なツールとなります。

2. Mocap Unleashed Network

a. ローカル・ネットワーク・ソリューション

Mocap Unleashed Networkは、ローカルネットワークフレームワーク内で動作します。そのため、すべてのコンポーネントが同一のネットワークサブネットに接続されている必要があります。このネットワークセグメントに接続されると、各コンポーネントは自らの存在をネットワークに通知し、システムが接続されたすべてのコンポーネントを自動的に認識できるようになります。

✅:システムのすべてのコンポーネントは、正常に動作させるために同一のローカルネットワークに接続されている必要があります。これらを同じネットワークに接続しない場合、コンポーネント同士が互いを認識できなくなります。

b. 高性能ネットワークの確保

システムの整合性とリアルタイム運用能力を維持するためには、10ギガビットカメラのデータスループット要求に対応できる十分に強力なネットワーク接続が不可欠です。これらのカメラはPCIeネットワークカードを介してサーバーに直接接続されています。最適なパフォーマンスを確保するためにも、高品質なネットワークケーブル、特にcat7ケーブル、もしくは短距離の場合にはcat6aケーブルを使用することが重要です。

✅:遅いケーブルや干渉を受けやすいケーブルを使用すると、システムのパフォーマンスに大きな悪影響を及ぼす可能性があります。CAT6aケーブルを使用する場合は、電源ケーブルから距離を保つように注意してください。CAT6aケーブルはシールドされておらず、電気的干渉を受けやすいため、これを防ぐための配慮が必要です。

c. ディープ・パケット・インスペクションの無効化

特定のアンチウイルスソフトウェア、例えばTrend-Microなどは、すべての送受信データに対してディープパケットインスペクションを実行することがあり、システムのパフォーマンスやデータスループットを著しく低下させる可能性があります。パフォーマンスの大幅な低下を防ぐために、これらのディープパケットインスペクションプログラムを無効にするか、例外設定を行うことを推奨します。

✅:ディープパケットインスペクションプログラムを無効にしない限り、深刻なパフォーマンス問題を引き起こす可能性があります。

3. 5MPカメラシステム

目次

1. Mocap Unleashed:8台の並列5GigEカメラのパワーを利用する

2. PCスペック

1. Mocap Unleashed:8台の並列5GigEカメラのパワーを利用する

Mocap Unleashedは、RGBベースのカメラと最先端のディープラーニングアルゴリズムを活用した、マーカー不要のモーションキャプチャソリューションです。本システムは、8台の並列GigEカメラからのデータを処理し、毎秒4.7〜8.7ギガピクセルのデータを生成します。この膨大なデータは強力なGPUによって綿密に処理されます。このため、システムの計算負荷は非常に大きく、高性能なリソースが必要となります。

AR 51のMocap Unleashedシステムのハードウェア仕様は、厳格なテストを経ており、コンポーネントの品質が低下すると、システムのパフォーマンスや速度が著しく低下する可能性があることを強調する必要があります。

2. PCスペック

マザーボードが2枚のネットワークカードとGPUの両方を使用できることを確認してください:

* pcieエクステンション用の空きスロットが2つあることを確認してください。ウォータークーリングを使用しない4090/4080カードはかさばります。

* 追加する2つのPCIスロットは、最低でもPCIe3 x 4モードを使用できる必要があります。

| コンポーネント | タイプ例 | インフォメーション |

| CPU | インテル Core i9 13900K / 1700トレイ | CPUは、ネットワークカードとGPUをサポートするために、最低でも**20 pcieレーン**が必要です。 |

| マザーボード | ギガバイトZ790 AORUS ELITE AX | 必要条件- RTX 4090用PCI-e 4- イーサネット拡張カード用PCI-eスロット×2(各3GByte/秒、PCIe3×4モード) |

| メモリー(RAM) | DDR5 64GB (32×2) 5200 Corsair | 最低速度:4000 |

| ストレージ(HDD) | SSD 1.0TB | 512GBでも十分です。 |

| GPU (RTX 4080) | ギガバイト RTX 4080 | ウォータークーリングを使用しない4090カードはかさばります。マザーボードにPCIeネットワークカードを2枚追加できるスペースがあることを確認してください。 |

| 水冷 | Corsair iCUE H150i RGB PRO XT リキッドCPUクーラー | ウォータークーリングを使用しない4090は非常にかさばり、2枚のpcieカードを置くスペースがなくなります。 |

| 2x PCI-eネットワークカード | Quad-port 5G POE+ Framer Grabber Amazon , Alibaba | 4xポート(各5Gbps、RJ45またはSFP+)を備えた2x PCIeネットワークカード。 |

4. 9MPカメラシステム

目次

1. Mocap Unleashed:8台の並列10GigEカメラのパワーを利用

2. PCスペック

1. Mocap Unleashed:8台の並列10GigEカメラのパワーを利用

Mocap Unleashedはマーカーレスモーションキャプチャソリューションとして、RGBベースのカメラと最先端のディープラーニングアルゴリズムを活用し、リアルタイムのモーションキャプチャを提供しています。当社のシステムは、8台の並列GigEカメラからのデータを処理し、合計で毎秒8.7ギガピクセルのデータを生成します。このデータは、強力なGPUによって綿密に処理され、計算負荷が大きいため、ハイエンドのリソースが要求されます。

AR 51のMocap Unleashedシステムのハードウェア仕様は、厳格なテストを受けています。コンポーネントの品質に妥協があれば、システムのパフォーマンスとスピードが著しく損なわれる可能性があります。

2. PCスペック

マザーボードが2枚のネットワークカードとGPUの両方を使用できることを確認してください:

* pcieエクステンション用の空きスロットが2つあることを確認してください。ウォータークーリングを使用しない4090/4080カードはかさばります。

* 追加する2つのPCIスロットは、最低でもPCIe4 x 4モード

を利用できる必要があります。

* 拡張例の拡張カードはPCI-e v4.0 x4を使用し、これらのSFPアダプタ も必要であることに注意してください。

| コンポーネント | タイプ例 | インフォメーション |

| CPU | インテル Core i9 13900K / 1700トレイ | CPUには、ネットワークカードとGPUをサポートするのに十分なレーンが必要です。 |

| マザーボード | 1.ASUS ROG STRIX Z790-E ゲーミング無線LAN2.Asus Prime-x670-p | 必要条件- RTX 4090用PCI-e 4- カード用PCI-eスロット×2(各6GB/秒の転送速度、PCIe4×4モード-各スロットに最低限必要 |

| 水冷 | Corsair iCUE H150i RGB PRO XT リキッドCPUクーラー | ウォータークーリングを使用しない4090は非常にかさばり、2枚のpcieカードを置くスペースがなくなります。 |

| メモリー(RAM) | Corsair DDR 5 64G (32×2) 5200 | 最低速度:4000 |

| ストレージ(HDD) | SSD 1.0TB | 512GBでも十分です。 |

| GPU (RTX 4090) | ギガバイト RTX 4090 GV-N4090GAMING OC-24GD | ウォータークーリングを使用しない4090カードはかさばります。マザーボードにPCIeネットワークカードを2枚追加できるスペースがあることを確認してください。 |

| 2x PCI-eネットワークカード | LR-LINK PCI-e v4.0 x8 クアッドポート 4 SFP28 (25G Intel E810) Amazon, Alibaba | |

| 8 SFP+ RJ45コネクタ Amazon,2,3 Alibaba | PCI-e v4.0カードが必要 |

5. 1.3MPカメラシステム

目次

1. Mocap Unleashed:8台の並列1GigEカメラのパワーを利用

2. PCスペック+ネットワークスイッチ

3. コンピュータを10Gigeスイッチに接続する3つの方法

1. Mocap Unleashed:8台の並列1GigEカメラのパワーを利用

Mocap Unleashedは、RGBベースのカメラと最先端のディープラーニング・アルゴリズムを活用し、リアルタイムのモーションキャプチャーを提供するマーカーレス・モーションキャプチャー・ソリューションです。当社のシステムは、8台の並列GigEカメラからのデータを処理します。このデータは、強力なGPUによって綿密に処理され、計算負荷が大きいため、ハイエンドのリソースが要求されます。

AR 51のMocap Unleashedシステムのハードウェア仕様は、厳格なテストを受けています。コンポーネントの品質に妥協があれば、システムのパフォーマンスとスピードが著しく損なわれる可能性があります。

2. PCスペック+ネットワークスイッチ

マザーボードがNvidia GPUをサポートし、10Gイーサネットカード用の空きPCIeスロットがあるか、追加の10Gネットワークポートがあることを確認してください。

| コンポーネント | タイプ例 | インフォメーション |

| CPU | インテル i7-13700F(または同等のもの) | CPUは、ネットワークカードとGPUのデータ転送を処理するのに十分なレーンが必要です。 |

| マザーボード | 必要条件- RTX 4070に対応するPCI-e 4- 代替1:10Gigeイーサネット拡張カード用PCI-eスロット×1(PCIe3×4モード)- 代替案2:10Gポートを増設したマザーボード。 | |

| メモリー(RAM) | DDR5 64G (32×2) 5200 Corsair | 最低速度:4000 |

| ストレージ(HDD) | SSD 1.0TB512GBでも十分です。 | |

| GPU – エヌビディア RTX4070 | ギガバイト RTX 4070 | RTX 4070なら何でも可能。ボードに10ギガのイーサネットカードを搭載するスペースがあることを確認してください。 |

| 10Gige PCI-eネットワークカード | TPlink – 10Gigeカード | 高速USB(ThunderboltまたはUSB3.2 Gen2)を搭載したコンピュータの場合、PCIネットワークアダプターの代わりにUSB-10Gコネクタを使用することができます。 |

| ネットワークスイッチ | ネットギア MS510TXPP | スイッチには1Gigeの接続が8本とPCへの10Gigeのアップリンクが必要です。カメラポートもPOE(パワー・オーバー・イーサネット)を提供するためにsfp+であることが必要 |

3. コンピュータを10Gigeスイッチに接続する3つの方法

PCには10Gigeのネットワーク接続が必要です。これにはいくつかの方法があります。

1.PCI-Eネットワーク10ギガ拡張カードを使用する。

2.マザーボードがデュアルネットワークであることを確認します。10ギガ接続イーサネット接続(スイッチに使用)とイーサネット接続(インターネット用)。

3.ThunderboltやUSB3.2 Gen2のような高速USBインターフェースを搭載したコンピュータでは、PCI-eネットワーク・アダプターの代替として、このようなUSB-to-10GigEアダプターの使用を検討してください。

6. 調節用の電球

目次

1. 調節球

2. 電球

1. 調節球

調節に使用される球は、通常、直径30CMの軽い球です。

広い範囲をカバーする場合は、より大きな球体を使用することも可能です。

2. 電球

少なくとも1800ルーメンの強い白色光が必要です。